#Carreiras

#Carreiras

Inteligência artificial: usos práticos e limites éticos na ciência

ChatGPT, SciSpace, Anara: para Rebeca Scalco, especialista em IA, ferramentas precisam “trabalhar” para os cientistas, e não o contrário

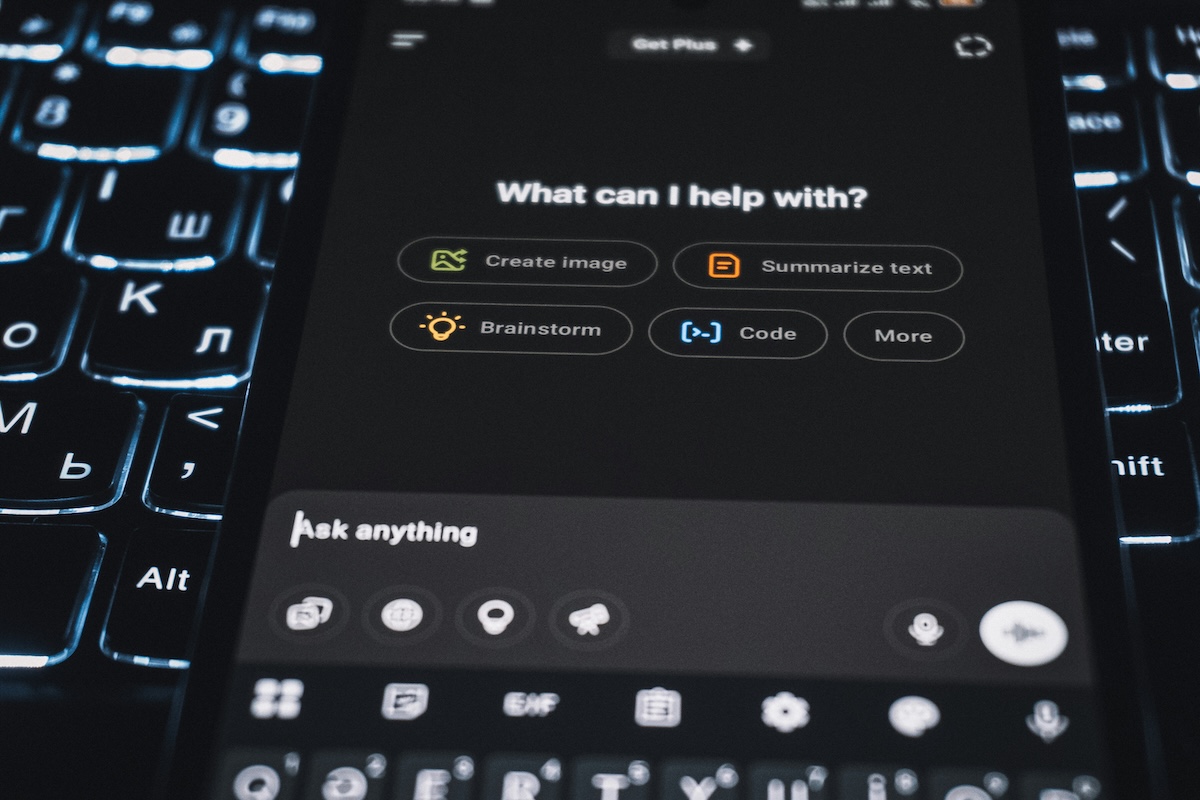

Ferramentas de IA generativa, como o ChatGPT, já fazem parte do cotidiano acadêmico de pesquisadores, auxiliando em tarefas como escrita, programação, revisão e organização de ideias | Imagem: Zulfugar Karimov/Unsplash

Ferramentas de IA generativa, como o ChatGPT, já fazem parte do cotidiano acadêmico de pesquisadores, auxiliando em tarefas como escrita, programação, revisão e organização de ideias | Imagem: Zulfugar Karimov/Unsplash

Muito antes da popularização do ChatGPT, a inteligência artificial (IA) já era realidade; ou, ao menos, uma inquietação. Nos anos 1950, o matemático britânico Alan Turing (1912-1954), conhecido por seu papel decisivo na Segunda Guerra Mundial (1939-1945), com a decifração de códigos criptografados, foi um dos primeiros a perguntar publicamente se as máquinas poderiam pensar – ainda que o termo “inteligência artificial” só tenha sido cunhado pela primeira vez em 1956 pelos norte-americanos John McCarthy (1927-2011) e Marvin Minsky (1927-2016).

Desde então, muita coisa mudou. O mais importante: as máquinas deixaram de apenas executar comandos para aprender com eles, armazenar e até aprimorar conhecimentos. Outro salto relevante foi a ampliação do acesso à IA, que chegou às mãos do público e passou a ser utilizada em tarefas cotidianas.

“Para mim, essa democratização da IA traz uma virada poderosa, pois é a primeira vez que a ferramenta está nas mãos dos usuários”, afirma a veterinária Rebeca Scalco, doutoranda em patologia digital e bioinformática na Universidade de Berna, na Suíça.

Especializada em áreas como desenvolvimento de modelos preditivos, bioinformática aplicada à saúde animal e novas tecnologias de sequenciamento genético, Scalco usa aprendizado de máquina (machine learning) e análise de dados em sua pesquisa.

Mais recentemente, a pesquisadora resolveu compartilhar o conhecimento acumulado em IA na forma de produtos e serviços para cientistas.

Entre eles, estão dois ebooks com dicas e soluções para pesquisadores que desejam integrar tecnologias de IA e automatizar processos de escrita e análise de dados. Scalco também passou a oferecer mentorias e cursos sobre o assunto.

Graduada pela Universidade Federal de Pelotas (UFPel), no Rio Grande do Sul, com mestrado pela mesma instituição, a veterinária esbarrou pela primeira vez com ferramentas avançadas de inteligência artificial quando fazia um estágio de pesquisa na Universidade da Califórnia, nos Estados Unidos.

O estudo era em medicina humana, e seu papel no laboratório de neuropatologia do Centro de Pesquisa com Alzheimer era acompanhar a dissecação de cérebros de pacientes e explicar a causa da morte.

O encontro com a patologia digital

Foi nesse contexto que conheceu a patologia digital, técnica em que lâminas histológicas contendo fragmentos de tecidos são digitalizadas e vistas por meio de imagens de alta resolução, dispensando o uso direto do microscópio.

“A partir da digitalização, é possível aplicar algoritmos sem afetar o material físico”, explica Scalco. “Como a patologia é essencialmente feita de padrões, há um encaixe perfeito com o aprendizado de máquina.” Na mesma época, surgia o ChatGPT.

“Passei a integrar o uso da IA generativa à minha rotina acadêmica. De um lado, para pesquisa; de outro, como ferramenta prática para organização, escrita e programação”, comenta Scalco.

Recomendações para usar ferramentas de inteligência artificial de forma ética em suas pesquisas

-

1. Declare o uso da IA

-

Assim como se faz com softwares estatísticos, informe nas seções de materiais e métodos quais ferramentas foram utilizadas. A transparência é essencial para manter a integridade científica.

-

2. Registre as ferramentas usadas em cada etapa

-

Manter uma planilha simples, com datas e fins de uso, ajuda na organização, facilita a prestação de contas e reduz riscos de uso indevido ou plágio acidental.

-

3. Trate a IA como um auxiliar, não como autor

-

Ferramentas generativas devem ser vistas como estagiários: podem ajudar muito, mas o trabalho final precisa passar por revisão crítica e ter autoria humana.

-

4. Atenção com dados sensíveis

-

Evite inserir em plataformas proprietárias dados inéditos, pessoais ou sigilosos. Avalie os termos de uso e as políticas de privacidade das ferramentas antes de compartilhar qualquer conteúdo sensível.

-

5. Conheça as diretrizes da sua instituição

-

Universidades como a Unicamp e a UFBA já estabeleceram normativas para uso ético da IA. Verifique se sua instituição também tem protocolos ou recomendações.

-

6. Mantenha o pensamento crítico como bússola

-

IA pode acelerar processos, mas a interpretação, a análise e a autoria intelectual continuam sendo responsabilidades humanas. Nunca delegue essas etapas.

Ferramentas para cada etapa do processo

Scalco conta que utiliza diversas tecnologias de IA em sua rotina acadêmica. O ChatGPT, segundo ela, tornou-se indispensável para estruturar textos, revisar clareza e fluência em inglês, gerar trechos de código (em Python e R), montar planos de aula e apresentações.

Para revisão de literatura, recorre ao SciSpace, que facilita a leitura de artigos complexos, e ao Anara, que sintetiza informações e gera explicações com base em fontes originais.

Usa ainda o ResearchRabbit e o Inciteful para visualizar redes de citações e identificar tendências de pesquisa.

“Em alguns casos, uso o Google Notebook LM para organizar notas e resumos. Cada ferramenta tem seu papel, mas o ChatGPT, aliado a uma boa plataforma de apoio à literatura, é a base do meu cotidiano”, afirma.

Ética e limites: IA como assistente

O uso da IA na academia já é realidade para milhares de pesquisadores. O tema, porém, divide opiniões. Enquanto alguns veem com entusiasmo, outros temem uma banalização do processo científico. Scalco reconhece ambos os lados e defende uma posição equilibrada.

“Essas ferramentas devem ser tratadas como bons estagiários, ávidos por aprender. Mas assim como o doutorando jamais submeteria um texto de estagiário sem revisão para uma publicação, tampouco deve encaminhar trabalhos feitos com IA sem a devida verificação”, alerta.

Casos recentes ilustram o mau uso:

- A revista Neurosurgical Review, da Springer Nature, precisou retratar dezenas de artigos gerados por IA sem a devida transparência.

- Um livro da mesma editora sobre machine learning também foi retirado após descobrirem referências falsas, as chamadas “alucinações” da IA.

Para Scalco, o caminho é relativamente simples:

“Declarar o uso da IA no material e métodos, como fazemos com softwares estatísticos. Recomendo manter uma planilha registrando qual ferramenta foi usada em cada etapa.”

De acordo com a pesquisadora, algumas universidades brasileiras já avançaram nesse debate, como a Estadual de Campinas (Unicamp) e a Federal da Bahia (UFBA). “Essas instituições publicaram diretrizes claras de uso ético da IA em pesquisas e trabalhos acadêmicos.”

IA como aceleradora da ciência

Utilizada com método, a IA pode ser grande aliada da pesquisa. Scalco aponta aplicações como esboço de textos, tradução de documentos, triagem de artigos, revisão de coerência, resumos e insights iniciais.

“A ferramenta SciSpace, por exemplo, ajuda a explicar artigos complexos, mas quem compreende, ou analisa criticamente é o pesquisador”, ressalta.

Em áreas como bioinformática, genômica e análise de grandes volumes de dados, a IA é praticamente indispensável.

Modelos algorítmicos identificam padrões genéticos, classificam células, preveem interações moleculares e aceleram descobertas com precisão inédita.

“Isso seria inviável com estatística clássica. A IA não substitui o pesquisador, mas amplia nossa capacidade de enxergar relações “escondidas” por trás de milhões de dados”, observa.

Questões regulatórias e geopolíticas

Apesar dos avanços, Scalco reconhece que as plataformas de IA são controladas por grandes corporações, com interesses econômicos e pouca regulamentação, especialmente no Brasil.

“Ao compartilhar dados sensíveis, precisamos pensar: quem está por trás dessa tecnologia? Quais os riscos? Vale mesmo entregar anos de pesquisa a uma empresa privada, sem garantias?”, questiona.

A União Europeia saiu na frente com o AI Act, aprovado em 2024, que estabelece categorias de risco, exigências de transparência e supervisão humana.

A Organização das Nações Unidas para a Educação, a Ciência e a Cultura (Unesco), por sua vez, publicou uma recomendação global sobre ética da IA, adotada por quase 200 países.

No Brasil, o Projeto de Lei 2338/2023 (PL da IA) está em discussão no Senado, abordando governança, responsabilidade civil e direitos fundamentais.

“Essas regras não são neutras. São fruto de disputas e lobbies”, afirma Scalco.

“Por isso, a academia e a sociedade civil precisam participar da regulação, garantindo que o interesse público esteja no centro, especialmente em áreas como a saúde”, defende.

Para a pesquisadora, a ideia é clara: que a IA trabalhe para o pesquisador, e não o contrário. “As pessoas estão delegando demais. A IA é potente, mas não pode nos anular. Nunca abra mão do seu pensamento crítico, do seu olhar e do seu poder reflexivo”, recomenda.

*

É permitida a republicação das reportagens e artigos em meios digitais de acordo com a licença Creative Commons CC-BY-NC-ND.

O texto não deve ser editado e a autoria deve ser atribuída, incluindo a fonte (Science Arena).